本文是《漫談

云計算網絡》系列的第一篇,本系列文章面向的對象為網絡工程師和對網絡技術感興趣的童鞋。作者從云計算網絡技術介紹,云計算網絡的架構模式以及在企業實踐SDN/NFV解決方案的經驗總結三個維度進行分享。

一、數據中心網絡技術的變革

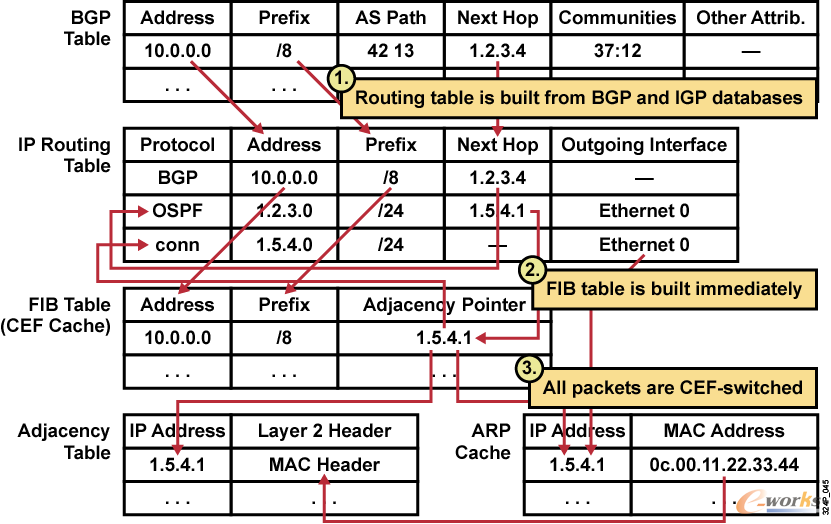

數據中心的網絡架構和技術在云計算誕生后,與數據中心的計算及存儲一起都在發生著變化。起初數據中心網絡分為內部與外部,數據中心外部網絡指的通常是三層網絡,也就是我們最開始所認知所學習的諸如:BGP、IS-IS、OSPF等三層路由協議的使用與三層網絡架構的設計,怎么才能規劃路由,怎么才能使得流量按照路由的規劃選址最優的路徑提供出去,如果說數據中心外部網絡關注更多的是提升用戶的體驗,那么數據中心內部網絡就是運維兄弟關注的重點之一,提升網絡系統的效率。數據中心內部網絡是云計算引入后發展非常迅速的一個領域,也是更新迭代最快的領域。最開始我們認知的數據中心網絡局限在同一個物理數據中心內部,隨著云計算的發展,數據中心網絡逐漸進化為同地域多物理數據中心的網絡被抽象成一個虛擬化的內部網絡,到現在不同地域乃至全球范圍的物理數據中心網絡都可以互相二層打通的云化網絡。

新的標準、新的架構、新的產品層出不窮,可延續、可擴展、高靈活、穩定的高度整合是越來越多的中心所追求的一個新的網絡體系架構。大二層網絡是在云計算引入進來以后引入的一個新的概念,曾經被定義為下一代數據中心網絡,原有的網絡架構由于沒有考慮二層網絡橫向擴展與交換原理的誕生時并沒有考慮到二層網絡會有今天如此之大的需求,二層網絡的困境逐漸的體現出來,不論是公有云還是私有云同樣都面對了同一個問題,就是傳統二層網絡問題,其中包括了二層網絡的廣播風暴、低延遲、STP生成樹協議的限制、二層網絡邊界逐漸擴大、vlan的數量問題、vlan tag的轉換、多租戶之間的私有網絡的靈活性問題迫使整個數據中心網絡在今天的云時代下已經發生了翻天覆地的變化。下面是筆者基于自己的理解,對云計算網絡中的技術應用進行的整理和總結

1.1 Overlay

隨著網絡變化越來越大,需求不斷改變,傳統的網絡設計思路的局限性逐漸凸顯,而且數據中心之間的通信本質還是依賴運營商提供的資源,如果有錢可以選擇裸光纖,但是IT本身就是為了業務更好更快地發展所提供的一種高效工具,那么更多的數據中心網絡其實還是依賴運營商的網絡,在這個網絡之上進行疊加加以利用,或者租用運營商提供的網絡資源,隨著越來越多需要疊加的邏輯網絡的需求不斷涌出,下面我們先來回顧一下網絡世界里不得不提,也是每一個網絡從業者所需要了解的一個網絡技術知識-Overlay。

Overlay的本質理念就是疊加,在原有的傳統網絡上虛擬出或者疊加出一個邏輯網絡來,傳統網絡不需要做任何改變,就可以將新的網絡通信協議在其上展開,其主要技術路線,就是對數據中心網絡的建設模式進行了完全的顛覆,原有的接入層、匯聚層、核心層的三層設計架構逐漸演變為二層匯聚與三層網關的葉脊架構。

圖1 Overlay

Overlay無狀態網絡技術也是未來數據中心網絡發展的一個重要組成部分。其主要意義就是疊加,通過其定義的邏輯網絡,實現業務所需要的邏輯網絡,從而解決數據中心云化的網絡問題,極大地節省了傳統的IT投資成本,Overlay也是一種將(業務的) 二層網絡構架在(傳統網絡的)三層/四層報文中進行傳遞的網絡技術。這樣的技術實際上就是一種隧道封裝技術。最關鍵的業務模型就是要實現一種無狀態的網絡模型,即使跨越運營商資源,也可以實現多個數據中心互訪,甚至虛擬機遷移都可以無感知地在這張邏輯網絡上運行,同時對上層應用提供無感知的網絡服務。

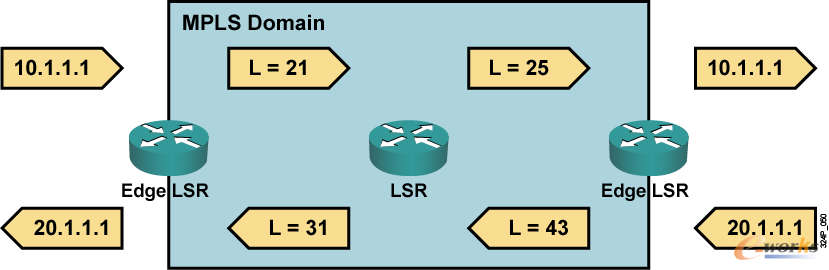

1.2 MPLS VPN

其實在網絡技術里已經有了不少的封裝技術,MPLS VPN就是其典型代表之一,在90年代初期,當時路由器由于轉發效率低下,無法保證完整的QOS設計等原因,其發展遠遠落后于網絡,當時的路由查找算法必須依賴軟件查找,路由器性能也會因此受到影響,網絡處于不重視結果的盡力而為的困境,ATM網絡隨后誕生,同時IP網絡中的MPLS也誕生出來。

MPLS(multi-protocollabelswitch)是Internet核心多層交換計算的最新發展。MPLS將轉發部分的標記交換和控制部分的IP路由組合在一起,加快了轉發速度。而且,MPLS可以運行在任何鏈接層技術之上,從而簡化了向基于SONET/WDM和IP/WDM結構的下一代光Internet的轉化。MPLS與鏈路層區分開來,定義為2.5層協議,可以在其網絡結構上承載其他報文,與1997年正式命名為MPLS。

通常,MPLS包頭有32Bit,其中有:

-

20Bit用作標簽(Label)標簽只有本地有意義不會缺少

-

3個Bit的EXP, 協議中沒有明確,通常用作COS

-

1個Bit的S,用于標識是否是棧底,表明MPLS的標簽可以嵌套

圖2 Mpls包頭結構

標簽(Lable):是一個比較短的,定長的,通常只具有局部意義的標識,這些標簽通常位于數據鏈路層的數據鏈路層封裝頭和三層數據包之間,標簽通過綁定過程同FEC相映射。

FEC(Forwarding Equivalence Class,轉發等價類):是在轉發過程中以等價的方式處理的一組數據分組, MPLS本來規定:可以通過地址、隧道、COS等來標識創建FEC,現在看到的MPLS中只是一條路由對應一個FEC:通常在一臺設備上,對一個FEC分配相同的標簽。(一組不同數據從相同的接口進來相同的接口出去)

LSP(標簽交換通道):一個FEC的數據流,在不同的節點被賦予確定的標簽,數據轉發按照這些標簽進行。數據流所走的路徑就是LSP。

LSR(Label Switching Router): LSR是MPLS的網絡的核心交換機,它提供標簽交換和標簽分發功能。

LER(Label Switching Edge Router):在MPLS的網絡邊緣,進入到MPLS網絡的流量由LER分為不同的FEC,并為這些FEC請求相應的標簽。它提供流量分類和標簽的映射、標簽的移除功能。(變IP轉發為標簽轉發)

MPLS VPN專業術語:

PE路由器:又稱作提供商邊緣路由器。該路由器負責用戶端網絡到提供商網絡的接入。

P路由器:又稱提供商路由器。P路由器是提供商網絡中不連接任何CE設備的路由器。

CE路由器:又稱用戶邊緣設備。CE路由器通過連接至一個或多個提供商邊緣(PE)路由器的數據鏈路為用戶提供對服務提供商的接入。

**VPN-IPV4地址:**VPN用戶通常使用私有地址來規劃自己的網絡。當不同的VPN用戶使用相同的私有地址規劃時就會出現路由查找問題。

路由區分符RD:路由區分符RD即VPN-Ipv4地址的前8字節,用來區分不同VPN中的相同私網地址。

路由目標RT:RT為MP-BGP中的擴展共同體屬性之一。路由目標屬性定義了PE路由器發布路由的一組站點(VRF)的集合。PE路由器使用這一屬性來對輸入遠端路由到其VRF進行約束。

VPN路由轉發表(VRF):每個PE路由器為其直連的站點維持一個VRF。每個用戶鏈接被映射至一個特定的VRF。每個VRF與PE路由器的一個端口相關聯。

圖3 數據結構

LDP方式傳遞:

圖4 Mpls domin LDP標簽交換

LSR控制平面:

圖5 控制平面

Edge LSR控制平面:

圖6 邊緣設備控制平面

1.3 MPLS VPN-VPLS

虛擬專用局域網業務VPLS(Virtual Private LAN Service)是公用網絡中提供的一種點到多點的L2VPN(Layer 2 virtual private network)業務,使地域上隔離的用戶站點能通過MAN/WAN(Metropolitan Area Network/Wide Area Network)相連,并且使各個站點間的連接效果像在一個LAN(Local Area Network)中一樣。它是一種基于MPLS(MultiProtocol Label Switching)網絡的二層VPN技術,也被稱為透明局域網業務TLS(Transparent LAN Service)。典型的VPLS組網如下:處于不同物理位置的用戶通過接入不同的PE設備,實現用戶之間的互相通信。從用戶的角度來看,整個VPLS網絡就是一個二層交換網,用戶之間就像直接通過LAN互連在一起一樣。

目前,隨著企業的分布范圍日益擴大以及公司員工的移動性不斷增加,企業中VoIP、即時消息、網絡會議的應用越來越廣泛,因此這些應用對端到端的數據通信技術有了更高的要求。端到端數據通信功能的實現依賴于一個能夠支持多點業務的網絡。

傳統的ATM(Asynchronous Transfer Mode)、FR(Frame Relay)技術只能實現二層點到點互連,而且具有網絡建設成本高、速率較慢、部署復雜等缺點。隨著IP技術的發展,一種在IP(Internet Protocol)網絡上提供VPN(Virtual Private Network)服務、可方便設定速率、配置簡單的技術隨之產生,這種技術即MPLS VPN技術。基于MPLS的VPN技術有兩種,分別是MPLS L2VPN和MPLS L3VPN:

傳統VLL(Virtual Leased Line)方式的MPLS L2VPN是在公網中提供一種點到點的L2VPN業務,不能直接在服務提供者處進行多點間的交換。

MPLS L3VPN網絡雖可提供多點業務,但PE設備會感知私網路由,造成設備的路由- 信息過于龐大,對PE設備的路由控制性能要求較高。

針對以上問題,VPLS在傳統MPLS L2VPN方案的基礎上發展而成,是一種基于以太網和MPLS標簽交換的技術:

由于以太網本身就具有支持多點通信特點,使得VPLS技術可以實現多點通信的要求。

同時VPLS是一種二層標簽交換技術,從用戶側來看,整個MPLS IP骨干網是一個二層交換設備,PE設備不需要感知私網路由。

因此,VPLS技術為企業提供了一種更加完備的多點業務解決方案。它結合了以太網技術和MPLS技術的優勢,是對傳統LAN全部功能的仿真,其主要目的是通過運營商提供的IP/MPLS網絡連接地域上隔離的多個由以太網構成的LAN,使它們像一個LAN那樣工作。

VPLS pw自動部署

圖片7 VPLS pw自動部署

BGP AD VPLS PW的自動部署過程詳細描述如下:

兩臺PE上屬于相同VPLS域的VSI根據到遠端(BGP AD中的Next Hop)的LDP會話狀態相互發起LDP Mapping(FEC 129)信令,其中攜帶AGI、SAII、TAII和標簽等信息。

BGP AD VPLS在成員發現后,采用主動觸發LDP協議創建LDP會話的方式,使LDP能夠按照業務的需求來建立會話。當VPLS業務撤銷,不再使用該LDP會話時,再主動觸發LDP協議拆除LDP會話。這樣既能減少LDP會話拓撲的維護工作量,又能提高系統資源的利用率,減少網絡資源的開銷,提升網絡性能。

PE接收到遠端的LDP Mapping(FEC 129)信令后,解析獲取VPLS-ID、PW Type、MTU、TAII等信息,將這些信息與本地VSI比較,如果協商通過,并且滿足建立PW的條件時,創建到對端的PW。

一個VPLS轉發實例:

圖8 VPLS轉發

VPLS限制:VPLS在過去mpls大規模發展過程當中,雖然解決了跨站點間的2層通訊問題,但是同樣對于運維人員來說就是一場噩夢,首先我們需要組建自己的一整張MPLS VPN的網絡,這里面就涉及到了資源的購買,或者直接租賃第三方的MPLS VPN網絡,但是租用網絡后,我們運行VPLS,就需要運維人員每天都去維護不同的pw,并且要在維護一張路由表的同時還需要維護一張Fwording Table(標簽轉發信息庫),除此之外,還需要運維人員維護不同的二層網絡。VPLS雖說一時解決了二層跨站點通信的問題,但是同樣它的缺陷也是顯而易見的,首先VPLS基于vlan的情況下,廣播,arp,生成樹協議依然存在;每個vlan的轉發依然是單邊走向路徑,冗余鏈路并不能及時利用,造成鏈路的浪費;過多的網絡資源實際是依賴運營商的網絡資源,運營商的網絡資源我想每一個數據中心都深有體會;同時,運維人員還要面對MPLS VPN 當中配置的復雜性,對于整個運維團隊在維護數據中心網絡的同時又增加了一個不小的挑戰。

1.4 LISP

LISP(Locator/Identifier Separarion Protocal——位置/身份分離協議)是為了改變由于云計算到來造成數據中心的資源地理位置的不確定性的通信問題的一種嘗試手段,從IP層協議進行介入,解決數據網絡在云計算大規模到來時的網絡瓶頸的一種嘗試性網絡技術。是一種添加了控制平面的IPsec VPN服務,并且可以輕松應對傳統vpn點到點與點到多點的業務需求模型。

LISP在傳統IP網絡層中添加了兩個重要的新的網絡元素:

ITR(Ingress Tunnel Router—-入向隧道路由器)

ETR(Egress Tunnel Router—-出向隧道路由器)

其轉發的基本原理為:部署在LISP網絡邊界的ITR路由器接受非LISP站點發來的數據包,并添加上新的ROLC包頭作為源包頭,依據LISP中ROLC的轉發規則進行路由查表轉發,到達位于LISP數據路徑的最后一站的ETR路由器,還原原始普通IP數據包,并轉發給傳統非LISP站點進行解封裝原始數據包。

相較于傳統的IP數據包,LISP最大的變化之一就是將IP數據包分為了外層與內層兩層數據包頭,外層為LISP通信的RLOCs,通常為一個ETR位置,內存攜帶的EID信息是一個非LISP常規站點信息。

圖9 LISP包頭信息

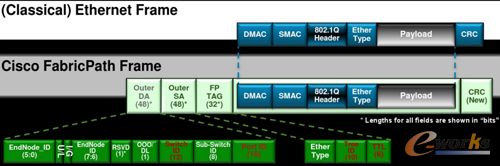

1.5 Fabric-Path

LISP還屬于典型的數據中心外部網絡設計技術方案,而數據中心內部網絡平臺才是將云計算各個系統之間串聯的關鍵網絡技術平臺。

隨著虛擬化技術的出現,數據中心網絡逐漸發生改變,現在的數據中心需要“一個大二層”網絡滿足多租戶內網與虛機遷移,同時只有靈活的二層網絡才能實現即插即用的特殊協議的應用需求。但是傳統網絡中為了避免二層環路所出現的二層特性STP(Spaning Tree)協議所構建的網絡與現在數據中心所需要的網絡模型確是背道而馳,即使是快速生成樹協議的30秒組網速度也不能滿足現在數據中心網絡所需,同時STP協議帶來最大的問題就是帶寬的浪費與根橋槍戰導致網絡中斷的問題。

特點:

新增一個二層幀頭(原地址、目的地址、TTL):

源地址和目的地址:新定義Switch ID的全新命名空間,最為唯一的標識,進行路由尋址。

增加一套簡化的IS-IS路由協議:

引入IS-IS路由協議作為控制層面的依據,鏈路狀態路由協議,相比MAC地址尋址這樣的距離矢量路由協議來說,鏈路狀態路由協議可以在整網當中更新一整張路由拓撲結構,新增加的節點與隨時更新整個鏈路狀態數據庫,從而達到從最短的距離上去轉發數據包。

Cisco FabricPath技術是一種二層交換技術與三層路由技術的融合體,它既擁有二層交換技術的易于配置,即插即用和快速部署的優勢。還擁有路由技術所獨有的多鏈路負載均衡,快速收斂和高擴展性的特點。是一種真正意義上二三層技術融合的產物。整個Fabric-Path交換網絡的組成可以看做是一個大的交換機也就是一個整體的二層交換域,但是其控制平面采用了三層路由協議IS-IS,每臺Fabric-Path交換機通過Switch ID來進行組網,Switch ID就像以太網中的IP地址一樣,是所有FabricPath交換機的唯一標示,實現了二層網絡在鏈路狀態路由協議上的轉發,免去了原有二層網絡設計的樹狀方式的不便捷性,同時實現了二層FULL-MESH架構。

圖10 數據包結構

圖11 組網拓撲

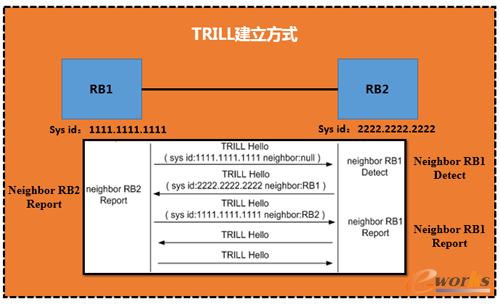

1.6 Trill

傳統二層網絡作為一種源于局域網互聯技術,一般采用xSTP協議防止廣播風暴,具有簡單易于維護等特點,在數據中心得到了廣泛應用。在目前階段,規模化、虛擬化、云計算已成為數據中心的發展方向。由于云計算數據中心對轉發帶寬的需求非常大,而且傳統的xSTP為了避免環路會阻塞某個端口導致部分帶寬的浪費,因此三層IP轉發作為一種過渡技術也被應用在數據中心。對于一些較大的數據中心提供商,一個數據中心的服務器容量已經不能滿足他們的需求,出于擴容和災備兩方面的目的,大型廠商通常會考慮建立多個數據中心。在擴容時,需要利用虛擬機遷移技術進行數據中心的建設部署。

隨著數據中心的規模不斷擴張,業務需求的不斷增大,服務器以及接入交換機都大規模增加,不管是傳統的二層網絡還是作為過渡的三層IP轉發都不能很好地滿足數據中心的需求。與TRILL協議相比,xSTP協議從適用的組網、網絡規模及帶寬利用率等方面都不具備優勢。另外,在傳統的IPv4和IPv6網絡中,由于設備的接口需要配置IP地址,造成IP網絡的配置復雜。而當一個接口由一個子網切換到另一個子網時,必須要改變它的IP地址,這也給虛擬機的遷移增大了管理成本。而且,為了避免地址的浪費,IP地址的管理也需要占用大量的人力資源。因此,三層IP技術的這些問題導致它在二層網絡中表現并不優越。TRILL作為大二層的控制協議,通過擴展IS-IS路由協議,把二層配置的靈活性與三層的大規模性有效結合在一起,部署方便。

2.6.1 Trill原理描述:

TRILL網絡中的設備名稱:

RB(Router Bridge):指運行TRILL協議的二層交換機。

DRB(Designated Router Bridge):指在TRILL網絡中作為中間設備被指定承擔某些特殊任務的RB。在TRILL廣播網中,兩臺RB如果處于同一個VLAN(Virtual Local Area Network),在建立鄰居關系時需要根據接口的DRB優先級或者MAC地址的大小來選舉DRB,DRB負責與網絡中每臺設備進行通信,最終使整個VLAN的LSDB(Link State DataBase)達到一致狀態,減少了多臺設備兩兩通信帶來的巨大開銷。

TRILL中的VLAN-

Carrier VLAN:

VLAN是將一個物理的LAN在邏輯上劃分成多個廣播域的技術。同一VLAN內的設備之間可以直接通信,而不同VLAN之間的設備不能直接通信,這樣,廣播報文被限制在一個VLAN內,保證了局域網的安全性。

Carrier VLAN用于承載TRILL數據和收發協議報文,不承載普通ETH數據報文,一臺RB最多可配置三個不同的Carrier VLAN。

CE VLAN:

CE VLAN也叫做接入VLAN,用以接入TRILL網絡,只負責承載普通ETH數據報文。

Designated VLAN:

指定VLAN,在TRILL網絡中需要指定某個Carrier VLAN為轉發數據流量及TRILL控制報文的VLAN,該指定的TRILL VLAN被稱為Designated VLAN,以下簡稱為DVLAN。

Nickname:

Nickname相當于IP地址,用來唯一標識一臺交換機。一臺RB僅支持配置一個nickname,且須保證nickname全網唯一。

TRILL協議地址結構

與IS-IS協議類似,TRILL協議采用NSAP(Network Service Access Point)地址結構,如00.1234.5678.9abc.00,可以看作由以下三部分組成:

Area ID:區域地址用來標識區域。與IS-IS不同的是,TRILL的區域地址規定為“00”。

System ID:系統ID用來唯一標識一臺主機或交換機,在設備的實現中,它的長度固定為48 Bit。

實際應用中,System ID可以自動生成也可以通過配置得到。自動生成的System ID與RB的橋MAC地址相同,如果手動配置的話,需要保證全網唯一。

SEL(Selector):作用類似IP中的“協議標識符”,不同的傳輸協議對應不同的SEL。TRILL協議的SEL為“00”。

NET

網絡實體名稱NET(Network Entity Title)指的是交換機本身的網絡層信息,可以看作是一類特殊的NSAP。例如有NET為:00.1234.5678.9abc.00,則其中區域地址為00,System ID為1234.5678.9abc,SEL為00。

圖12 TRILL建立方式

圖13 TRILL報文格式

Trill雖然是大二層網絡的一個新型的擴展協議,對于數據中心內部的組網來說,小規模部署還是沒有問題的,但是對于數據中心未來的發展,個人認為其并不是最理想的網絡架構模型,首先trill解決了二層網絡環路與生成樹的限制性問題,但是其在一個組播組下所組建的vlan實例數量是有限的,并且trill并沒有真正解決二層網絡當中vlan不足的問題,同時無法在傳統網絡上進行疊加,也就是設備選型必須統一,而且不能跨越任何運營商網絡,也就是不能達到多站點間網絡部署的規劃,那么對于云計算來說,trill這種網絡協議不能隨著時代進步而替代現有網絡架構,其也并沒有解決vlan tag轉換的問題。那么多個數據中心直接vlan domain仍然同屬一個vlan domain空間。

1.7 OTV

VPLS的到來其實要早于云計算的到來,最初的VPLS到來只是為了增添IP協議與ATM之間的一場爭奪戰,VPLS本身可以建立二層網絡在三層網絡上的傳遞,但是由于其依托于MPLS VPN對于企業來說不管從技術部署與運維層面,還是從網絡資源方面都是一個不小的挑戰,廣播、load-balance、stp、ARP這些限制性問題依然存在,后來的LISP、Fabric-Path、Ttill等新起的大二層網絡協議也都是屬于一個數據中心內部的二層網絡協議,但是當云計算到來的今天,越來越多的數據中心不再局限在單個機房內部或者虛擬資源池的規模也不會只是屬于單一的數據中心,越來越多的需求由單數據中心逐漸的引申到多數據中心組網,二層網絡也會隨之延伸至全地域,對于數據中心二層網絡的需求對于之間的協議也就帶來了新的挑戰。

圖14 OTV

OTV是cisco2010年在其數據中心Nexus 7000上發布的一項軟件特性,OTV實際是一種VPN隧道技術,簡化了數據平面機制,不用再像VPLS一樣維護眾多尾纖(PW),是一種基于IS-IS作為控制層面的對MAC地址進行尋址的VPN協議。可以作為TRILL或者Fabric-Path的城域網版本的協議。路由表中將MAC地址需要通過哪個OTV節點進行表項化,MAC尋址更像路由協議,每個OTV節點的路由信息在第一個數據包發送出去后就已經進行了信息同步,同Fabric-Path和TRILL,是一種類似鏈路狀態路由協議,本質是在廣域網鏈路架構了一個Overlay的疊加網絡。

OTV控制平面依據Hello報文進行鏈路信息同步,同時支持兩種控制平面傳輸模式,一種為組播模式,一種為單播模式,區別在于當運營商網絡支持組播,每個OTV節點發送一個Hello報文就可以將整個OTV網絡信息進行同步,每個OTV節點都會幀聽到相同的組播地址所發布的Hello消息。單播模式情況下,那么需要OTV節點一對一的進行Hello報文的傳遞,直至所有節點都發送完畢,才建立一張整體OTV邏輯網絡。同時OTV可以基于vlan進行廣域網流量負載均衡,比如基于奇數vlan與偶數vlan分別進行load-balance。

圖15 支持組播的原理圖

圖16 僅支持單播流量的廣域網

OTV在當時是一款非常不錯的跨站點的網絡協議,在跨越運營商網絡的同時,節省昂貴的專線費用。但是由于其協議的屬性屬于私有協議,對于一般的中小企業可能難以支持其昂貴的價格,但是不可否認,OTV在對于高密度出口交換機當中的一個完整解決架構,確實是一個非常不錯的架構方式。在運營高密度交換機時,可以將云計算底層虛擬化流量全部匯聚到Spine層交換機上,承載了大量的二層流量,同時可以對外BGP的方式與運營商對接,既可以承載出口流量,也可以承載數據中心內部穿越SITE的二層內部流量,對于東西向流量橫向擴展來說,具有歷史性的意義。

圖17 運營商骨干網

1.8 Vxlan

Vxlan是由Cisco、VMware、Broadcom等廠家向IETF提出一項云計算環境下,大二層網絡解決方案的一項草案,全稱Virtual eXtensible Local Area Network,即虛擬擴展本地網絡。虛擬化技術大規模部署的到來,使得原有的軟件服務同物理硬件的分離,單個程序或者單個系統不用在單一的硬件物理服務器上運行,同時實現了硬件服務器的資源池化,保證了業務的連續性。一個完整的應用系統有著更大的發展,網絡、存儲、安全等問題逐漸的出現在整個資源池當中,而貫穿這些聯系的因素之一就是網絡,全萬兆網絡的架構方式改變了原有的低延遲問題,但是其本質還是屬于物理架構的方式,內部各個邏輯網絡的建立都以租戶的形式體現出來,每個租戶的隔離,每個虛擬網絡的隔離,每個業務的隔離,都會耗費大量的vlan,隨著vlan 的不足,數據中心規模隨之逐漸擴大,多SITE的需求逐漸顯現,那么每一個SITE之間的VLan domain不應該再按照原有的網絡部署模式去規劃,即同屬于一個網絡vlan domain內。原來沒有的領域開始了逐漸的變化,已更好的為當下云計算體系服務,不管數據中心或者運營商都是如此,數據網絡的變化就是其一。

圖18 云計算

面對這些問題,我們不得不去面對,也不得不去解決,要跨過vlan、廣播、生成樹這些等等傳統的限制問題,網絡必須進行改革,Overlay的技術逐漸體現出來,Vxlan實際上利用的原理跟OTV實現的方式差不多,但是更多得是Vxlan的支持力度卻要遠遠大于OTV的支撐力度。

Vxlan實際上定義了一個Vtep的實體(VXLAN Tunnel End Point—虛擬擴展本地網絡隧道終極節點),將虛擬化產生的流量由原有的vlan封裝模式完全變為vxlan的封裝模式,將產生的數據包轉變為UDP的包頭從內部發出,虛擬化本身的MAC地址等二層信息則會封裝在內層包頭內,Vtep的封裝工作可以是虛擬化層或者硬件層面,但是其消耗的性能指標是我們需要考慮的一項因素。如果在虛擬化層面實現Vtep的封裝工作,那么底層虛擬化流量在到達機頂交換機的時候,就已經被打上了Vtep的標簽,換句話說,底層流量對于上層網絡的唯一需求就是三層可達,那么對于云計算這個系統內部,若轉變成三層協議進行轉發,那么就回歸到了傳統的路由協議里面,這樣的網絡轉發的效率與安全性就會大大增加,原有的STP等限制性因素就逐漸被打破了。

虛擬機本身的信息對外已經不可見,對外看到的只是一個傳統的IP數據包,Vxlan通過新得網絡標識VNI來對每一個租戶的網絡進行隔離,VNI取代了原有的vlan tag標識,VNI是一個24 bit的二進制標識,傳統的4096個vlan的上限,VNI將可以達到16萬7千VXLAN網絡段,從而解決vlan 不足、vlan tag的轉換問題,同時解決了多站點間同屬于一個vlan domain的困境。

UDP包頭:

目的端口使用4798,但是可以根據需要進行修改。UDP的校驗和必須設置成全0。

IP頭(外層的新三層頭):

外層頭的IP地址不再是原有的虛擬機通信雙方的地址,而是隧道兩端的網絡地址,虛擬化層面來說也就是軟件服務器的地址網卡IP地址,目的IP地址可以是單播地址,也可以是多播地址。單播情況下,目的IP地址是Vxlan Tunnel End Point(VTEP)的IP地址。在多播情況下引入VXLAN管理層,利用VNI和IP多播組的映射來確定VTEPs。

protocol:設置值為0x11,顯示說明這是UDP數據包

Source ip: 源vTEP_IP;

Destination ip: 目的VTEP IP。

外層二層頭:

不再是原有的真實MAC地址,而是虛擬化軟件服務器的MAC地址或者物理交換機封裝Vtep隧道的接口MAC地址,這樣完全就建立一個新的二層頭部,而內層真實的頭部在到達隧道終點將會自動進行解封裝,重新封裝原有數據包,實現了跨越三層傳遞二層信息的技術。

圖19 新的VXLAN幀頭

Vxlan數據平面:

VTEP為虛擬機的數據包加上了層包頭,這些新的報頭之有在數據到達目的VTEP后才會被去掉。中間路徑的網絡設備只會根據外層包頭內的目的地址進行數據轉發,對于轉發路徑上的網絡來說,一個Vxlan數據包跟一個普通IP包相比,出了個頭大一點外沒有區別。

由于VXLAN的數據包在整個轉發過程中保持了內部數據的完整,因此VXLAN的數據平面是一個基于隧道的數據平面。

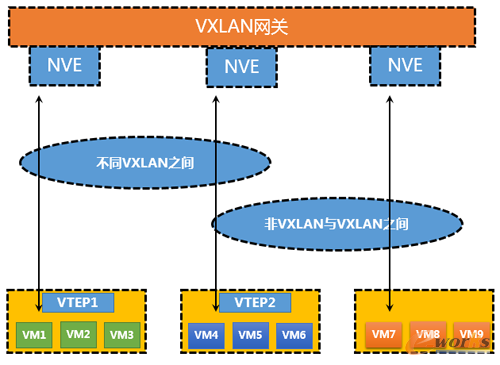

部署場景:

純vxlan場景:這種場景完全可以按照傳統的部署方式去部署vxlan網絡,在虛擬化層虛機直接打上vxlan的標簽。

Vxlan與vlan的混合模式:對于這種部署場景,需要一個叫做二層vxlan gateway才可以將vlan與vxlan之間進行對應,并且實現二層通信,當二層流量匯聚到三層網關時,傳統SVI接口承載的是vlan模式的trunk流量,那么對于vxlan的解決方式,我們可以借用vxlan網關進行二層流量的終結,路由到運營商網絡出網。

圖20 Vxlan與vlan的混合模式

1.9 EVI

對于Vxlan來說,也許對于傳統來說可能是一種選擇。但是對于跨越運營商的網絡,尤其是運作大型數據中心網絡,如IDC,云服務提供商來說,想要建立一張完整的跨地域大二層網絡,僅僅依靠Vxlan技術是不足的,evi技術可以說是基于mpls的一個整體二層邏輯網絡,可以跨域運營商網絡的同時,不用依靠mpls就可以建立遠端鄰居,將統一流量接入相同EVI就可以實現跨地域甚至跨越全球的私有網絡建設。有人會說,VXLAN也可以實現類似的隧道機制,但是隨著云計算的到來,我們忽視mac地址數量,PBB-EVPN的技術可以實現在邊緣設備進行MAC地址匯聚,這樣在建設全球性私有邏輯網絡的時候,就能夠對虛擬云主機的MAC地址進行匯總并宣告出去,經過隧道傳遞的圖中,不用擔心類似MAC地址的追蹤,暴露自己私有MAC地址的行為。保證了整體數據中心的私有安全性問題。

圖21 EVI原理圖

如圖,接入端(AC)接入,首先建立EDGE BD 為每條AC,分配一個I-SID編號,通過建立CORE BD 并且與 EDGE BD相互關聯,匯聚成為一個EVI,每個evi相當于一個vpn實例,將封裝在不同vlan的子端口,橋接到一個EVI當中,路由器對數據包進行重新封裝,可以進行不同vlan間的2層通訊,在3層網絡上,壓入標簽進行轉發傳遞主機信息,從而達到跨越數據中心的主機進行2層通訊。

圖22 Mac地址學習

圖23 多冗余機制

圖24 負載均衡機制

二、對SDN/NFV的理解

SDN: SDN(software Defind Networking,軟件定義網絡)是一種由云計算的發展而帶來的數據中心網絡架構的升級,最大的特點就是其具有松耦合的控制平面與數據平面、支持集中化的網絡狀態控制,實現了底層網絡對于上層應用的透明,具有靈活的網絡編程能力,使得網絡自動化管理與控制能力獲得了空前的提升,能夠有效地解決當前網絡系統所面臨的資源規模擴展受限,網絡與業務難以進行緊密結合的需求等問題。

圖24 SDN/NFV分析

NFV: NFV(Network Function Virtualization)是ETSI與2012年11月成立了專門用于討論NFV架構和技術的ISG(Industry Specification Group,行業規范組),其目標是基于軟件實現網絡功能并使之運行在種類廣泛的業界標準設備上,NFV目前的重點是對網絡功能進行虛擬化實現,它更多的實現是在OSI 4至7層的業務應用,NFV架構將控制層面進行了更細致的劃分,提出了段到段(End to End,E2E)的網絡控制層,能夠對多個數據中心或者運營商實現不同技術,按需供給網絡模型。同時也是實現SDN理念的一項專門技術方案。

SDN實現了集中控制,開放接口,網絡虛擬化三大特性。

集中控制:

邏輯上的集中控制是網絡資源的全局信息可以根據業務需要進行統一的資源池化和調配,例如:全局負載均衡、全局的流量工程等。同時集中控制使得整個網絡可以看一個整體,無需向傳統網絡一樣主意的對單獨的設備進行CLI的HOP by HOP的配置,減少了原有的配置復雜性難題。

開放接口:

同構開放的南北向接口,實現網絡和應用的無縫聯系,使得應用在需要時直接可以自定義屬于私有的邏輯網絡,現有的網絡可以承載成百上千的邏輯網絡。網絡可以實現按需獲取,按需分配的機制。

網絡功能虛擬化:

通過南向接口,屏蔽底層物理硬件設備,實現上層對于底層完全無感知,并且在需要的時候可以通過中央控制器獲得網絡相應的服務功能,包括虛擬防火墻,虛擬路由器,虛擬負載均衡器等等傳統硬件設備所實現的功能。同時不再受具體設備的物理位置的限制,邏輯網絡支持多租戶共享,支持多租戶的定制等需求。

SDN目前支持的主流功能方面也是基于Overlay的技術設計,進行相關網絡功能的實現。該設計思想主要是解耦、獨立、控制三個方面。

解耦:是指將網絡的控制從物理網絡當中脫離出來,可以以plug-in等方式融入到虛擬化層面,通過虛擬化層面的統一調度,控制底層硬件設備,傳統的底層硬件設備處于完全的數據平面進行轉發相應的流量即可。滿足用戶對網絡資源的按需交付的需求。

獨立:是指該類方案承載IP網絡之上,只要IP可達,便可對相應的虛擬化網絡進行部署,而無需對原有的物理網絡架構進行任何改變,便捷地在現有網絡上部署和實施。

控制疊加:邏輯網絡例如Vxlan網絡通過軟件編程的方式進行統一控制,網絡資源、計算資源、存儲資源等資源會被統一調度與控制并能根據上層需要進行按需交付,也可以實現虛擬化網絡與物理網絡設備進行協同工作,從而實現網絡完全的自動化機制,通過在節點間按需搭建虛擬網絡,實現網絡資源的虛擬化。

Openstack是業界知名的開源云計算管理平臺,它提供了豐富的管理能力,已經被眾多云計算需求者所接受。在其設計與實現中,與業界領先的AWS進行了對標,當前的Openstack已經具有非常完備的服務體系,主要由compute、Glance、Swift、Neutron、Dashboard、Keystone等組件組成,其中Neutron作為核心組件,已經實現了SDN的基本設計理念,并且對于相關主流網絡技術實現網絡功能的虛擬化,將應用與網絡進行了緊密的結合。

Neutron:Neutron基于一個可插拔的架構,提供基于租戶隔離的從二層到七層的虛擬化網絡服務,它作為一個框架提供了統一的網絡資源模型,而各個網絡廠商或者不同的網絡方案可以基于這個統一的模型來做具體的實現,就是Neutron中的插件,比如L2 agent或者L3 agent、dhcp agent等,并且neutron還為傳統的二層到七層的網絡服務提供了統一的北向編程接口,并且為二層到七層的網絡分別實現了可擴展的插件結構,如支持二層網絡的ML2插件,支持三層網絡的核心組件,實現高級網絡服務,例如負載均衡器、防火墻、VPN服務、路由協議等高級網絡特性。如今,Neutron已經成為Openstack中網絡虛擬化的核心項目,各家廠商可以實現他們自己的驅動來支持他們自己的網絡設備,甚至可以將完整的SDN產品與OpenStack集成起來。

SDN同其他網絡技術不同,它并不是針對某個項目的具體技術的革新,而是去顛覆現有組網的方式與設計理念,比如:OpenFlow的價值:“不在于Flow,而在于Open”,開源的精髓也就是在于開放,好比Neutron一樣。

我們可以去暢想SDN模式下的網絡架構,可能會類似今天的手機、硬件廠商只提供了一個基礎平臺,如果需要任何服務功能,我們都可以去相應的商店去下載,而不會受制于手機本身平臺的限制。

SDN的真正使命其實是搭建一個完全開放,自主可控,按需所取得高靈活性,高可靠性的網絡平臺。

OpenFlow代表了一波網絡潮流的防線,而握著最廣泛的行業資源和客戶關系的傳統網絡廠商的支持無疑會加快Openflow的成熟,傳統廠商的選擇可能成就它們下一個十年的輝煌,但是,在開源主導一切的時代下,對于傳統可能也是衰敗的開始。

三、未來數據中心網絡與運營商網絡的發展方向

在當下云計算快速發展的時代,尤其是運營商和企業,其數據中心越來越多地開始向云化網絡架構發展。傳統的網絡發展方向、傳統的網絡思想、傳統的網絡工程師要么轉型,要么就會錯過這場精彩的變革。眾多國內外運營商預計將會在2020年到來之際完成網絡轉型,企業數據中心與運營商的網絡模型將會有75%是由軟件控制和管理,越來越多的控制單元將會通過SDN和NFV放入到云或者最終用戶手中,網絡工程師的工作模式也會轉變。運營商的競爭對手可能是不止運營商之間,越來越多的競爭對手會變成像亞馬遜、Google云服務公司。Google曾經說,它并不是光纖網絡,而是一種可提供“身體所需的用以維持活性、能力和動力”的可食用維生素。面對越來越多的互聯網服務公司的業務“跨界”,運營商不得不去調整業務和技術方向去做市場競爭。

通過虛擬化、分解與重組,使數據中心與運營商的系統更加靈活、可靠、安全和高效,通過逐漸接受開源平臺,使得IDC與運營商可以靈活配置和開發軟件定義服務,而不用再去雇傭大量運維人員去維護這一切,底層將會完全透明、無感知的運行,加速整個云的生態系統成長。

數據中心與運營商等傳統網絡企業渴望轉型,然而這一切并不容易,迎接新技術、新的服務模型、我們就必須對現有的員工與技術人員一起培訓、否則一切都是空想,若不接受開源軟件,將會被這個時代所淘汰,從而錯過了一場歷史性的IT變革。

現在人們每天面對的都是各種云計算互聯網公司,如果傳統數據中心與運營商不再轉型,將不得不面臨被徹底管道化、廉價化和邊緣化的命運。過去終究會過去,過去的璀璨不代表將來的收益,過去已經過去,云的里程碑不再刻有曾經的名字。

四、一個網絡工程師對未來的暢想

多年以前,網絡或者通信工程師們,都是將各種電線插入交換板卡,而現在都是在將各種光纖插入各種板卡當中,將電話兩頭接起來,就可以進行通信,一個以硬件為主導的全硬件時代已然來臨。今后,隨著數據中化通信時代的到來,所有通信硬件設備都將注入帶有各種特性的軟件。但是,隨著芯片技術的發展,晶體管越來越多,通信設備并沒有跟上高速發展的計算機時代,由于之前我們都過于依賴硬件,每個設備功能體現都不同,也就是每個通信設備的功能與性能都比較單調,隨著云計算的到來,互聯網高速發展,通信網絡也逐漸面臨一場實現萬物互聯的設想,而硬件設備的私有化,硬ni ne件架構設計的固有思想,將逐步落后于時代的發展。

現在,我們可以通過虛擬化,將傳統硬件轉變為軟件,通過軟件實現傳統硬件所展現的功能,并將各功能模塊進行重組,重新融入到云計算中,這也許意味著,修改某個配置、實現某個功能,只需要幾行代碼也許就可以搞定,如果我們不接受這一切,數據中心與運營商將無法超越互聯網時代快速反應市場的變化,直致慢慢淡出這個世界,落寞地謝幕。

網絡將面臨一場前所未有的變革時代,新的網絡模型將會去分析大量數據與信息,并且在相應時間內做出快速反應,基于大數據平臺量身定制的業務投放,快速疏導智能交換等通信系統。

理想是豐滿的,而現實總是骨感,如果缺乏創新,缺乏接受云計算到來的學習心態,缺乏接受現實的勇氣,缺乏對于新技術的使用與維護能力,盡管對硬件操作游刃有余,但是在面對海量數據、程序化的世界,大數據、云計算等新的概念完全爆發的時候,要么接受,要么錯過。

核心關注:拓步ERP系統平臺是覆蓋了眾多的業務領域、行業應用,蘊涵了豐富的ERP管理思想,集成了ERP軟件業務管理理念,功能涉及供應鏈、成本、制造、CRM、HR等眾多業務領域的管理,全面涵蓋了企業關注ERP管理系統的核心領域,是眾多中小企業信息化建設首選的ERP管理軟件信賴品牌。

轉載請注明出處:拓步ERP資訊網http://www.guhuozai8.cn/

本文標題:漫談云計算網絡:云計算網絡技術介紹(一)

本文網址:http://www.guhuozai8.cn/html/consultation/10839719311.html